21世紀經濟報道記者孔海麗、實習生王甜 北京報道

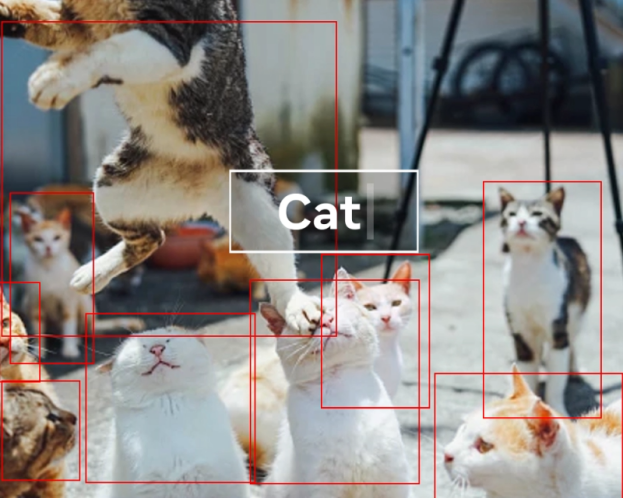

繼2023年4月首次推出SAM,實現對圖像的精準分割后,Meta于北京時間7月30日推出了能夠分割視頻的新模型SAM 2(Segment Anything Model 2)。SAM 2將圖像分割和視頻分割功能整合到一個模型中。所謂“分割”,是指區別視頻中的特定對象與背景,并可以追蹤目標。

SAM 2將圖像分割能力泛化到了視頻領域,其響應能力和準確度是一代的6倍,也是目前最優秀的視覺分割模型。Meta AI發布此版本時強調:“相信我們的數據、模型和見解將成為視頻分割和相關感知任務的重要里程碑。”

同日,扎克伯格在與黃仁勛的對談中,透露出更多Meta 的AI進展,包括將推出一款基于Llama3.1模型構建的名為AI Studio的新工具,允許用戶創建、分享和設計個性化的AI聊天機器人,用戶還可以在社交媒體平臺上分享他們的人工智能角色。

“細分一切”

SAM 2可以識別視頻中的特定對象,并實時實現該對象的追蹤與提取,在視頻編輯與特效制作中,可以高效輔助工作。該模型也可以根據用戶具體訴求,選擇分割某個物體或某個區域,使控制更加精準。

與其他模型不同的是,SAM 2擁有對不熟悉物體和圖像的零樣本泛化能力,無需額外訓練,只需單擊一幀視頻中的任何物體,即可實現對目標對象的實時追蹤,快速處理未來每一幀。

除此以外,該模型還可以集成到更大的系統中,它善于從其他智能系統中獲取提示,使系統之間完成協作。例如,SAM 2能夠在AR/VR穿戴式設備中選擇用戶注視對象,也可以讀取分割對象的邊界框提示,完成文本提示到視頻圖像分割的轉化。

為了訓練SAM 2,Meta自己建構了一個數據引擎——SA-V數據集,有效收集大量多樣化的視頻分割數據集并利用其去迭代模型。SA-V數據集包含5.1萬個視頻和64.3萬個時空分割掩碼(即masklet),是迄今為止最大的數據集,收集了47個國家/地區地理分布各異的真實世界場景的視頻。SAM 2就在Meta開源的SA-V數據集上進行訓練,為SAM 2提供的注釋包括整個物體、部分物體和物體被遮擋的情況。

SAM 2模型輔助人類標注目標對象的掩碼,與此同時,SAM 2將標注的掩碼傳播到視頻其他幀,生成時空掩碼,接受提示的SAM 2受益于對象在時間維度上的記憶,生成掩碼預測。如此循環往復,使SAM 2得到不斷更新。業內觀點認為,SAM 2為視覺數據提供更快的注釋工具,有望被用來訓練下一代計算機視覺系統。

對于視頻中的動態物體,SAM 2如何精準識別呢?Meta為SAM引入了一種記憶機制。對于視頻,記憶組件可以存儲對象的有關交互信息和之前處理過的信息,使SAM 2能夠在整個視頻中實現預測行為。根據其提示式設計理念,如果在其他幀上提供了相關提示,SAM 2還可以根據存儲的對象記憶上下文(前后幀)有效地糾正其預測,顯著減少人工標注時間。

Meta官網提供了一個例子,目標對象被遮擋或從視野中消失。為了向模型解釋這種新的模式,在SAM 2里新應用了“遮擋頭”模型,用于預測當前幀中是否存在目標對象,判斷物體是否可見,即使在物體暫時被遮擋時也有助于分割物體,使SAM 2能夠有效地處理遮擋。

不過,當遇到長時間遮擋或者場景中有多個相似對象等情況時,SAM 2可能會丟失對物體的跟蹤或是混淆物體。但同時,以上情況可以通過人為干預提供細化提示來解決。

盡管Meta自曝了SAM 2的不足,用戶對該模型的未來依然寄予厚望。

在以往的視頻編輯技術中,視頻摳圖需要一幀一幀地編輯。比如,國內明星真人秀節目數次遇到的“因某明星個人危機,需重新剪輯全部畫面”問題,可能不再需要視頻剪輯通宵達旦、連續加班。

SAM 2的應用范圍廣泛,在許多需要實時反饋的應用場景中將發揮其作用,包括自動駕駛、醫學、視頻拍攝剪輯、監控等。比如,捕捉動態對象實現實時交互,提高車載計算機視覺系統的敏銳性;在輔助醫學治療中,定位腹腔鏡攝像機錨定的區域;在追蹤攝影中,幫助無人機鏡頭跟隨追蹤瀕危動物;在機場、車站人流密度大的區域實時監控人群,預警異常情況;也為視頻內容博主提供了更多視頻創意創作的可能性。

更好的開源生態

SAM 2也為新模型的出現埋下伏筆。SAM 2的分割生成結果可以輸出給其他AI系統(例如現代視頻生成模型),SAM 2本身也可以接受其他AI系統的輸入提示,實現與目標對象的實時交互,比如,應用于直播時的AI公眾形象搭建,自動駕駛路況分析等。

為了使學術界能夠在目前的基礎上繼續研究,Meta公開發布了預先訓練的SAM 2模型、SA-V數據集、演示和代碼。值得注意的是,盡管需要巨大算力支持,SAM 2仍堅持開源,并允許廣大用戶免費使用(在Amazon SageMaker平臺上托管)。這讓Meta龐大的透明開源生態又添一員。

近期,扎克伯格多番強調了人工智能開源的意義,他曾撰寫的長文中表示:“開源人工智能比任何其他現代技術都更具有潛力,可以提高人類的生產力、創造力和生活質量,同時還能加速經濟增長并推動突破性的醫學和科學研究。”

“當今大多數領先的科技公司和科學研究都是建立在開源軟件之上的。最重要的是,開源人工智能代表了世界上利用這項技術為每個人創造最大經濟機會和安全的最佳機會。”扎克伯格補充說。

在與黃仁勛的對談中,扎克伯格也再次表達了“希望下一代計算機發展回到開放生態系統獲勝的局勢”。